Do primeiro computador do mundo até hoje: a história da Informática

Mesmo sem completar um centenário desde a invenção do primeiro computador, sua tecnologia evoluiu de modo astronômico

Se o século XIX ficou marcado por conta das primeiras Revoluções Industriais, os século XX e XXI foram marcados pela chegada do primeiro computador, que desde então evolui a passos gigantescos. Apesar de os primórdios dos computadores terem acontecido ainda no século XIX, foi na primeira metade do século XX que vimos a primeira "supercalculadora", uma máquina capaz de fazer cálculos melhor que os humanos.

E foram elas que fizeram surgir os primeiros computadores, que evoluíram e hoje são usados para trabalhar, estudar e se divertir. Assim como a evolução da televisão (artigo cuja leitura também recomendamos!), é importante notar que o computador ainda não chegou ao seu primeiro centenário.

O melhor de tudo: apesar de estar a cerca de 15 anos de alcançar o centenário, não faltam opções promissoras de futuro para essas máquinas. Além de contar para você sobre todos os avanços e revoluções na tecnologia, vamos também comentar sobre o que ainda pode mudar e nos impressionar nesse curto tempo. Da mesma maneira que fizemos em nossa reportagem especial sobre o celular do futuro.

Do primeiro computador ao computador do futuro: um pequeno resumo

Como está a computação hoje e o que se espera do futuro?

Supercalculadoras: antecessoras do primeiro computador

O conceito para o primeiro computador digital foi criado pelo matemático Charles Babbage, ainda no século XIX. Ele também trouxe o conceito da primeira memória RAM, ou seja, um dispositivo capaz de armazenar dados temporários para trabalhar no futuro. O conceito da máquina se chamava Difference Engine (Máquina Diferencial, em inglês), e usaria rodas dentadas para apresentar os cálculos.

Enquanto a Máquina Diferencial ainda era considerada um conceito de computador mecânico, a Analytical Engine (Máquina Analítica, em inglês) já trazia semelhanças com o que vemos em computadores da atualidade. Por meio de instruções enviadas por cartões perfurados, a máquina seria capaz de realizar cálculos mais complexos do que o conceito anterior.

Só que tanto a Máquina Diferencial quanto a Máquina Analítica não foram reconhecidas como os primeiros computadores por conta de um simples fato: elas não foram produzidas ou construídas, foram apenas idealizadas. Ainda assim, foi a Máquina Analítica que serviu de base para os computadores como os conhecemos hoje.

Inclusive, o método de inserir comandos e requisições de cálculo por meio de cartões perfurados se tornaria uma realidade no futuro e perduraria por muitos anos, mas seu conceito não foi criado por Babbage, mas sim pela mulher que viria a ser reconhecida como a primeira programadora.

Ada Lovelace: a primeira programadora

A ideia de usar cartões perfurados para a inserção de instruções na Máquina Analítica não veio de Babbage, mas sim de Ada Lovelace. Essa ideia foi inspirada na máquina de tear de Jacquard, que usava esses cartões para criar padrões nos tecidos trabalhados na máquina.

A ideia fez com que o conceito da Máquina Analítica não se limitasse aos números, como pensada originalmente, mas permitiria a ela também criar imagens. Ou seja, antes mesmo de o primeiro computador existir, Ada Lovelace já pensava no dispositivo como uma ferramenta multifuncional. Maneiro, né?

O primeiro algoritmo veio a partir de uma convenção na qual Babbage apresentou o conceito da Máquina Analítica. Depois dessa apresentação, um engenheiro italiano chamado Luigi Menabrea publicou um artigo em francês sobre a máquina.

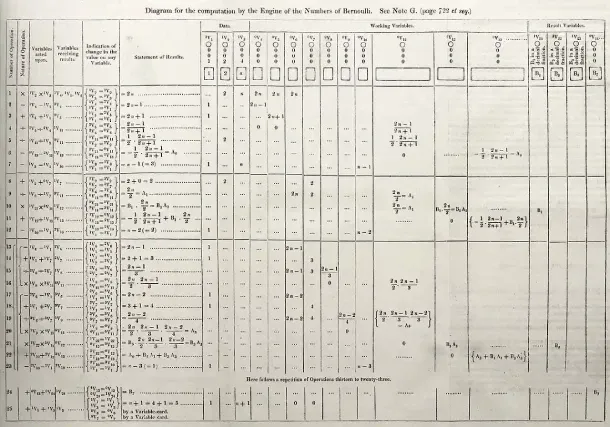

Ao traduzir o artigo para o inglês e incluir suas próprias notas, mais extensas que a própria publicação, Ada Lovelace acabou por criar a primeira sequência de cálculos feitos exclusivamente para um computador. O objetivo era usar o algoritmo para calcular os números de Bernoulli, uma famosa sequência matemática.

Considerando que a Máquina Analítica acabou não sendo criada na época, isso significa que o primeiro programa foi criado antes mesmo do primeiro computador!

A guerra e o primeiro computador

Foi apenas 100 anos depois dos conceitos de Babbage e Ada Lovelace que o primeiro computador surgiu, com as pesquisas na área de informação surgindo de maneira quase simultânea na metade final da década de 1930. Estados Unidos, Inglaterra e Japão já estavam a desenvolver novos conceitos e trabalhar em projetos para a criação do primeiro computador.

O período pré-guerra e ao longo da própria Segunda Grande Guerra foram onde os projetos de computadores começaram a se tornar realidade. Como a Inglaterra e os Estados Unidos entraram na Segunda Guerra em épocas diferentes, vamos retratar esse período com duas linhas: a americana e a inglesa.

Primeiro computador na Inglaterra: quebrando códigos

Os feitos de Alan Turing não se limitam à Segunda Guerra Mundial, mas foi o serviço que ele fez durante o conflito que serviu como base para a máquina que ficou famosa por quebrar o Enigma, um sistema de códigos usado em transmissões por rádio pelos nazistas, que tinha a particularidade de mudar diariamente.

Nessa tese, publicada em 1936, Turing criou o conceito de uma máquina capaz de identificar um problema e realizar quaisquer cálculos necessários para a sua solução, da mesma maneira que um humano. Vale notar aqui que os conceitos anteriores mencionavam apenas uma máquina capaz de realizar cálculos inseridos por humanos, que ainda precisavam pensar na lógica para a solução do problema.

Essa é base pela qual os computadores atuais operam até hoje e a tese em si está disponível para leitura (em inglês) em uma página dedicada a arquivar os trabalhos do pai da computação.

Foi após se tornar um criptógrafo para o exército britânico durante a Segunda Guerra que Alan Turing criou a primeira máquina baseada em seu conceito. A máquina foi construída em 1940 e recebeu o apelido de Victory (vitória, em inglês), sendo capaz de decifrar o código nazista em pouco tempo. Isso fez com que os Aliados recebessem milhares de informações militares alemãs diariamente, o que foi decisivo na vitória do bloco. Além de criar a base que ditaria a rápida evolução dos computadores nos anos seguintes.

Essa história é retratada no filme "O Jogo da Imitação", em que Alan Turing é vivido pelo ator Benedict Cumberbatch, o mesmo que interpreta o Doutor Estranho nos filmes do Universo Marvel.

Primeiro computador remoto nos EUA

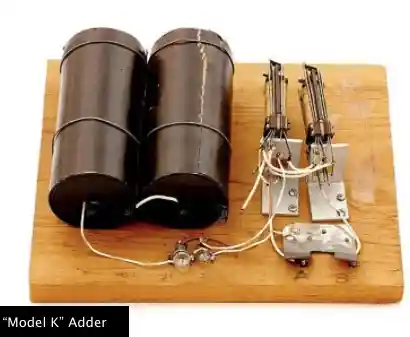

A criação do primeiro computador é creditada ao matemático George Stibitz, que criou a primeira máquina de cálculo binária. Ela foi chamada de Model K por ter sido construída na mesa da cozinha da casa do matemático.

A máquina podia fazer somas usando duas lâmpadas e um relés telefônico, que ofereciam as respostas de forma binária. O relés telefônico é a peça responsável por controlar e transmitir sinais elétricos, possibilitando a troca de informações entre os aparelhos, tanto que eram usados nas centrais telefônicas da época.

O matemático descobriu, no entanto, que a peça podia realizar operações de modo sequencial, a usando na montagem de seu Model K para realizar cálculos de soma binariamente. Ou seja, devolvendo as respostas acendendo as lâmpadas de valor "verdadeiro" ou "falso" em sequência.

Apesar de não ter sido recebida como uma máquina impressionante, ela foi a base para o próximo computador de Stibitz. Chamada de Model 1, a máquina terminou de ser construída em 1940, no mesmo ano que a Victory de Alan Turing.

Usando os princípios por trás do modelo caseiro, mas bem mais sofisticada, a máquina era capaz de realizar operações complexas de multiplicação e divisão, podendo também somar e subtrair em uma modificação futura. Enquanto o Model K usava um relés telefônico ligado à duas lâmpadas, o Model 1 contava com cerca de 450 relés binários e oito painéis, além de alguns relés multipolares usados para armazenar temporariamente números usados nos cálculos.

Outra contribuição importante do engenheiro mecânico está na área de redes e telefonia, já que o Model 1 podia ser controlado remotamente por meio de linha telefônica e um teletipo, que conhecemos melhor aqui no Brasil como o antigo Telex.

Antes de encerrarmos esse trecho, vale mencionar que nessa época, mais precisamente em 1939, nascia uma das primeiras empresas de informática a perdurarem até hoje: a Hewlett-Packard, conhecida hoje pela sigla HP e famosa por suas impressoras multifuncionais!

Primeiro computador eletrônico: o ENIAC

Você sabia que o nome computador veio justamente por sua habilidade de fazer cálculos? Como mostramos no começo da matéria, a intenção da máquina era a de realizar cálculos melhor do que um humano. Mas, ainda no século XIX, o potencial de transformar o computador em uma máquina multitarefa foi notado.

O computador continua sendo uma máquina de cálculos. A diferença que o tornou um dispositivo muito mais avançado do que uma mera supercalculadora foram os programas, escritos por meio de algoritmos.

É através deles que o computador te permite navegar na internet, editar imagens e vídeos, escrever textos de forma organizada e se divertir. Só que, antes deles, essas máquinas costumavam ter um propósito único. O computador criado por Alan Turing, por exemplo, tinha a única função de quebrar códigos militares inimigos todos os dias.

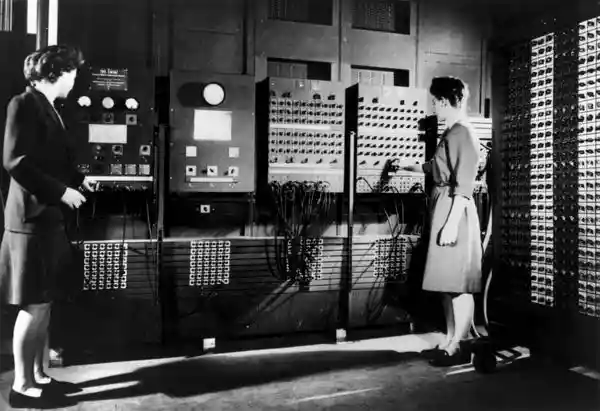

Além disso, esses computadores ainda contavam com muitas partes mecânicas, o que tornavam os cálculos lentos. Mas isso mudou com a chegada do ENIAC, o primeiro computador majoritariamente eletrônico.

Criado especificamente para realizar cálculos balísticos ainda na Segunda Guerra Mundial, o ENIAC podia ser usado para outras funções, já que podia receber instruções por algoritmos. Ele também era gigantesco, exigindo um cômodo e todo um sistema de ventilação para lidar com o calor que gerava.

O ENIAC era composto por milhares de capacitores, relés, interruptores e tubos à vácuo. Porém, era a máquina de cálculo mais rápida já inventada. Tanto que, em apenas uma década de existência, estima-se que o primeiro computador composto por componentes eletrônicos já havia feito mais cálculos do que toda a história da humanidade.

Anos depois, o NPL Pilot Ace foi construído com o propósito de poder receber novas funções a partir da inclusão de códigos de programação, sem a necessidade de adicionar novos aparatos físicos.

Nos anos seguintes, o computador foi evoluindo em direção à forma como o conhecemos hoje, com a invenção do primeiro teclado e com os primeiros modelos similares ao computador pessoal, mas que eram acessíveis apenas para empresas ou para o setor militar.

Ao longo das décadas de 50 e 60, os computadores começaram a evoluir, permitindo mais cálculos. Só que eles ainda eram peças exclusivas de forças militares e do meio corporativo. Foi apenas no começo da década de 70 que a revolução do primeiro computador pessoal aconteceu.

Um dos primeiros computadores pessoais foi o Kenbak-1, que tinha apenas 256 bytes de memória e usava interruptores de luz para operar. Lançado em 1971 e custando 750 dólares, ele não foi muito bem sucedido, vendendo apenas 40 unidades, o que causou o fechamento da Kenbak. Ainda assim, ele foi uma peça importante na nossa história por ser um dos primeiros computadores pessoais, que não precisava de um cômodo exclusivo para ele e podia fazer parte da sua casa. Esse ano também traz um importante marco: a criação do Intel 4004, o primeiro microprocessador do mundo, usado apenas nos computadores corporativos e que ocupavam um cômodo inteiro.

Foi em 1973 que o primeiro protótipo para o PC como o conhecemos hoje surgiu. Desenvolvido pela IBM, ele viria acompanhado de uma tela CRT, um teclado e uma entrada para fitas cassete. Só que, antes da chegada do IBM PC, a Apple de Steve Wozniak e Steve Jobs surgiria no mercado com o Apple-I, lançado em 1976. Ele foi o predecessor de um dos computadores pessoais mais populares e que viria a ser um dos carros-chefe da Apple por muitos anos: o Apple-II, lançado já no ano seguinte.

O Apple-II tinha uma grande vantagem que o manteve no mercado por alguns anos: a possibilidade de adicionar periféricos ou trocar peças, tornando o computador um componente personalizável, da mesma maneira que podemos fazer com os melhores computadores atualmente.

Outro marco do Apple-II é que ele abriu as portas para diversas empresas de tecnologia tentarem conquistar esse mercado. Foi nessa época que computadores clássicos como o MSX, Commodore 64, ZX Spectrum e Amiga surgiram, entre muitos outros.

Porém, esses computadores vinham com a proposta de atender a quem já era um entusiasta de computação, sendo mais proibitivos para quem não acompanhava o mercado. Apesar de extremamente nichados na época, existia um enorme vácuo de mercado, que foi ocupado por uma das principais rivais da Apple: a IBM.

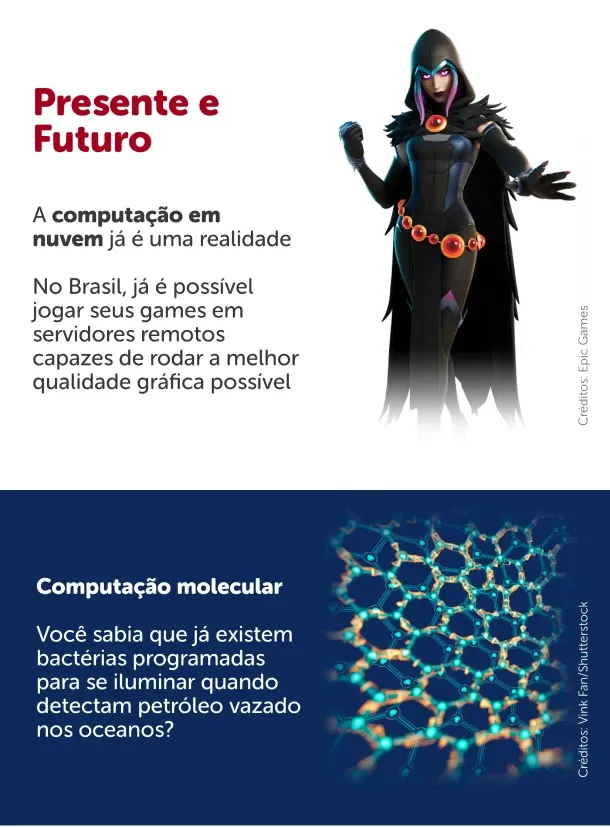

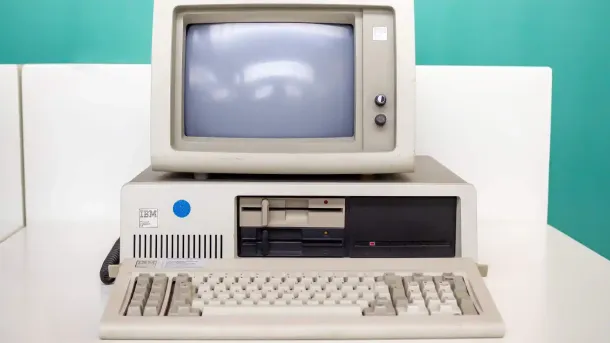

Foi em 1981 que a IBM introduziu o conceito de computador pessoal, que até hoje reconhecemos pela sigla PC. Diferente do computador da Apple, ainda considerado um produto para entusiastas de tecnologia, a proposta do IBM 5150, mais conhecido como IBM PC, era exatamente o contrário: ser um computador que todos pudessem usar. A meta era a democratização do computador - e, de quebra, o domínio de um novo mercado e a criação de uma nova necessidade para os consumidores.

Para isso, eles contaram com a ajuda de uma pequena empresa que viria a ser uma das gigantes tecnológicas da atualidade: a Microsoft de Bill Gates. O sistema operacional do IBM PC também se tornaria um dos mais queridos, cultuados e lembrados até hoje, mesmo para aqueles que já cresceriam com o Windows: o PC-DOS, criado especialmente para o IBM PC e depois comercializado pela Microsoft como MS-DOS. Se você usa o Windows como sistema operacional, a mesma interface ainda existe no seu PC hoje: é o prompt de comando.

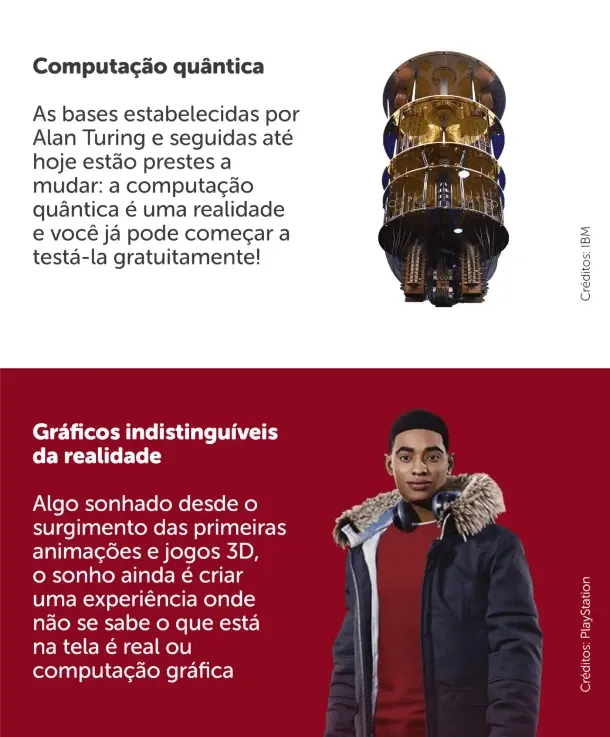

O sucesso do IBM PC fez com que a Apple prestasse atenção em outro mercado, ao invés de mirar apenas nos entusiastas. Como o Apple-II era um sistema muito aberto, ele requeria muito conhecimento por parte dos seus usuários para que fosse usado com sucesso.

Dois anos depois do lançamento do IBM PC, a Apple entra na disputa lançando o primeiro MacIntosh, em uma propaganda agressiva no Super Bowl de 1984, acusando a IBM de monopolizar o mercado e usar seus computadores como uma espécie de "Big Brother", fazendo alusão à distopia criada no livro "1984", de George Orwell.

O MacIntosh seria o primeiro computador criado com a filosofia que Steve Jobs estendeu para a Apple e ainda é um conceito muito forte em produtos como o iPhone e o iPad: o foco em oferecer a melhor experiência ao usuário.

Enquanto a história da informática começa no século XIX, foi apenas na metade final do século passado que a computação começou por aqui. Historicamente, o primeiro computador no Brasil foi o Patinho Feio, construído na Escola Politécnica da USP em 1972 por conta de um contrato feito entre a instituição e a Marinha brasileira.

Já os computadores pessoais só começaram a surgir no mercado brasileiro a partir de 1981, com brasileiros que viajavam para países com mercado já estabelecido, como EUA e Japão, os trazendo para cá. As primeiras empresas brasileiras de informática, no entanto, começaram a surgir a partir da década de 1980, quando uma iniciativa de reserva de mercado local começou a ser implementada no Brasil. Promulgada em 1984, ela vigorou por oito anos, até o seu fim em 1992.

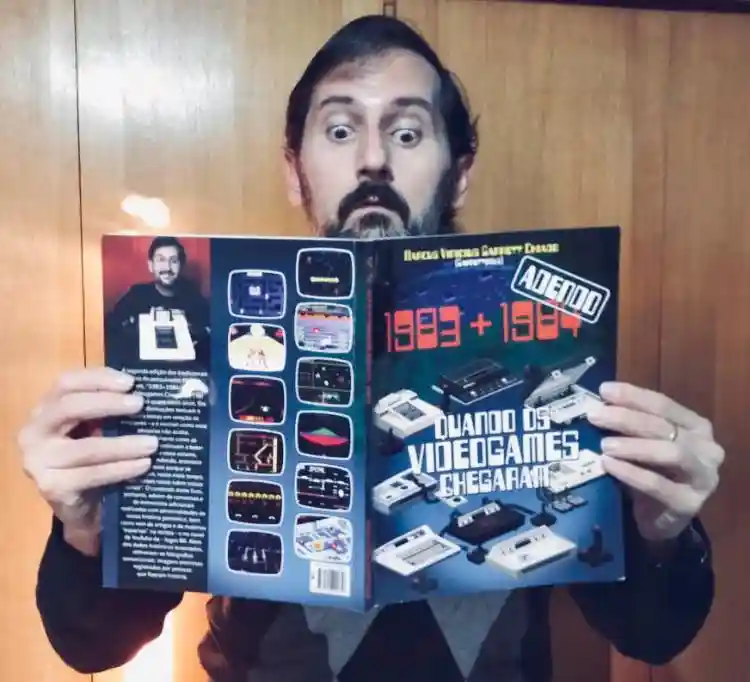

De acordo com Marcus Garrett, autor do livro 1983+1984: Quando os Videogames Chegaram e pesquisador sobre essa era da informática e games, essa iniciativa consistia na proibição de importação de produtos de informática para o Brasil, assim como não permitia o estabelecimento de empresas estrangeiras no país. As proibições, inclusive, não se limitavam aos eletrônicos.

Sabia que é por conta de políticas protecionistas que crianças das décadas de 1980 e 1990 cresceram com Comandos em Ação e Banco Imobiliário, ao invés de G.I Joe e Monopoly? Mesmo após o fim dessas políticas, ambos os nomes se tornaram tão marcantes que se estabeleceram, ainda que os nomes originais pudessem ser usados.

A criação dos primeiros computadores pessoais no Brasil

O pesquisador, que acompanhou a chegada dos primeiros computadores pessoais no Brasil, nos contou que os primeiros computadores pessoais no Brasil eram, essencialmente, "cópias dos computadores trazidos de fora".

Em conversa com a redação do Zoom, ele especificou que as empresas nacionais de informática que estavam se estabelecendo por aqui conseguiam acesso a computadores como os já citados Apple-II e TRS-80 e aplicavam engenharia reversa. Ou seja, desmontavam os computadores e aprendiam como era a sua fabricação.

A partir daí, eles fabricavam computadores clones, simplesmente usando o mesmo método, mas alterando alguns detalhes como "gabinete, nome e cor, mas em essência eram todos cópias. A Dismac, por exemplo, lançou um clone do TRS-80 em 1980. A Microdigital lançou clones do ZX80 e ZX81 em 1981 e 1982. A Nova Eletrônica, do grupo Filcres, lançou o NE Z80 e depois o NE Z8000."

Por outro lado, o fato de serem clones ocasionou problemas, já que, além do preço elevado, eles tinham performance inferior aos computadores originais. Vale mencionar também que os clones eram de computadores que já estavam obsoletos na época, então, apesar do crescimento do mercado de informática, a qualidade dos equipamentos não era a melhor. Ainda assim, os efeitos da política de reserva de mercado não foram totalmente negativos, como frisou o autor.

"A ideia era que se criasse essa tecnologia no Brasil, por isso a "proteção" contra coisas que vinham de fora. Era como se o Brasil estivesse "blindado" para os equipamentos e as empresas do estrangeiro. Mas muitos engenheiros e técnicos se formaram com esse boom da microinformática pessoal no Brasil na época."

Outro fator que é importante mencionar é que o mesmo fenômeno também aconteceu na indústria de videogames. O NES, primeiro console de mesa da Nintendo, só chegou ao Brasil por meio de seus clones, como o Phantom System e o Dynavision, entre outros. Foi apenas em 1992, com o fim da política de reserva de mercado, que passamos a ter representações oficiais, resultando na chegada do Super Nintendo oficialmente no país, um dos videogames mais queridos e nostálgicos da história do Brasil e do mundo.

O primeiro computador móvel: nosso famoso notebook!

A história do primeiro notebook se entrelaça com a do primeiro computador pessoal. Isso significa que alguns eventos que vou mostrar aqui aconteceram de forma quase simultânea, especialmente ao longo da década de 1980, uma das mais agitadas da história da Informática.

O Osborne-1 é considerado hoje como o primeiro laptop (computador de colo, em inglês), sendo lançado em 1981, antes mesmo do PC da IBM. Não faltaram conceitos que o antecederam, especialmente no final da década de 1970. Xerox, Epson, Microsoft e Toshiba são algumas das empresas que também viriam a desenvolver seus próprios conceitos.

Alguns chegam a mencionar que o próprio IBM PC de 1982 pode ser considerado um computador de colo. Só que tanto o IBM PC quanto o Osborne-1 tinham um problema em relação à portabilidade: eles eram pesados demais e dificilmente conseguiam ser usados no colo, como é a proposta de um laptop.

Tanto que o primeiro laptop no formato "caderno", que é o padrão até hoje, foi o TRS-80 Model 200, fabricado pela Radio Shack, popular rede de lojas de eletrônicos nos EUA. Lançado em 1985, o padrão foi repetido por praticamente todos os concorrentes, que incorporaram funcionalidades como a adição de drives para CDs e, claro, mais poder computacional.

Embora, no início de sua história, os computadores portáteis fossem usados e comprados para uso com editores de textos e planilhas, hoje é possível encontrar modelos de notebooks gamers cuja performance compete em igualdade com muitos dos melhores computadores de mesa. Olha só a diferença entre os notebooks antigos e um notebook gamer capaz de rodar todos os jogos atualmente.

Laptop vs notebook: qual é o nome certo?

Considerando o nosso mercado, é impossível dizer que notebook é a forma errada de chamar o computador portátil. Nos primórdios dos notebooks que mostramos acima, é possível notar que o nome se popularizou devido ao formato que permite abrir e fechar o computador.

Porém, o nome "notebook" acabou se popularizando apenas por aqui, enquanto nos Estados Unidos o "laptop" prevaleceu. Ou seja, é perfeitamente comum buscar por notebooks em lojas físicas e o ecommerce. Até mesmo nós desistimos de usar o nome certo, como pode ver na vitrine a seguir.

Porém, fica aqui a dica se estiver viajando para a terra do Tio Sam em busca de um "computador de colo": se pedir para ver notebooks, é possível que o vendedor te indique a seção de cadernos da loja!

Ao longo da história do primeiro computador e da evolução da Informática, veio também a evolução dos primeiros jogos eletrônicos. Embora os próprios computadores que ocupavam uma sala inteira já fossem capazes de rodar jogos bastante simples, o hobby era exclusivo de alunos das universidades e funcionários da própria indústria.

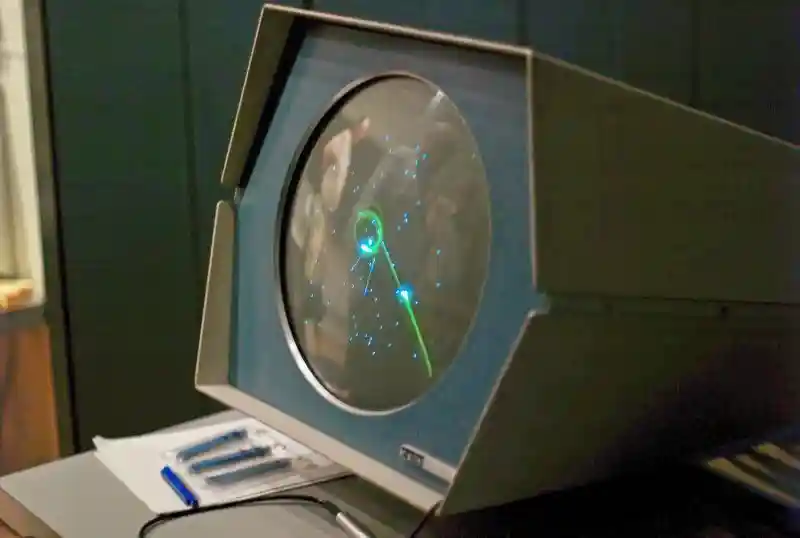

Spacewar! é reconhecido como o primeiro jogo de computador da história e foi lançado em 1961 para o modelo PDP-1. Ele consistia em uma disputa entre dois jogadores, que controlavam naves espaciais e deveriam derrotar um ao outro para se sagrar vitoriosos.

Só que a afirmação de que o Spacewar! foi o primeiro jogo de computador ainda é contestada atualmente. Onze anos antes dele, um jogo chamado Bertie the Brain foi exibido em uma convenção anual de exibições no Canadá, em 1950. Ele colocava humanos para desafiar uma inteligência artificial em partidas do famoso "jogo da velha".

Porém, por ter sido uma atração durante essa convenção e desmontada logo após seu fim, o Bertie the Brain foi considerado uma máquina de jogos. Algo como um fliperama, mas não um jogo para computador propriamente dito. Só que é importante notar que Bertie the Brain foi a primeira máquina de jogos a contar com inteligência artificial cujo nível de dificuldade podia ser programado.

Foi apenas no final da década de 1970 que os jogos de computador saíam dos laboratórios de informática americanos para as casas dos fãs de tecnologia. A primeira leva de jogos para computadores pessoais era constituídos, em maioria, por aventuras baseadas em texto. Depois, gráficos começaram a se tornar um fator cada vez mais presente, misturando comandos em texto com imagens e animações gráficas.

A partir daí, vimos o surgimento de fenômenos como Doom, os primeiros jogos de Warcraft e Half-Life, entre muitos outros. Parte da história da criação de Doom é contada em um divertido documentário da Netflix, GDLK, com entrevistas dos inventores do game sobre as dificuldades e a criatividade para serem pioneiros nesse tipo de jogo.

Nessa época, todo o processamento do jogo, incluindo os gráficos, era feito apenas pelo processador, que continha um componente chamado acelerador gráfico. É o que hoje costumamos chamar de placa de vídeo onboard, ou integrada. Até hoje a placa integrada é comum em notebooks que não são voltadas aos jogos.

Fundada em 1993, a NVIDIA é atualmente a única empresa totalmente focada na criação das placas de vídeo dedicadas. A AMD, sua maior rival nesse mercado, também compete na área de processadores com a Intel.

Em entrevista exclusiva para o Zoom, Richard Cameron, presidente da NVIDIA no Brasil, afirma que foram sim os jogos que tornaram a criação de uma peça dedicada ao processamento gráfico uma necessidade. Inclusive, o executivo nos contou que o próprio termo GPU (Graphic Processor Unit, ou Unidade de Processamento Gráfico) foi cunhado pela própria NVIDIA.

Dois anos após sua fundação, a NVIDIA lançava no mercado sua primeira placa de vídeo dedicada: a NV-1, com 2MB de memória RAM dedicada para vídeo (hoje, chamada de VRAM) e compatível apenas com a primeira versão do DirectX.

Cerca de 25 anos depois da aparição da NV-1, as placas de vídeo dedicadas não apenas se tornaram componentes essenciais para games, mas também para uso de programas de edição de vídeo ou imagem, parte da revolução da indústria audiovisual com a digitalização desses processos artísticos.

Sua importância é tanta que o componente se tornou essencial para algumas profissões, como mostramos nessa lista de notebooks para AutoCAD, software que é referência para arquitetos e engenheiros, como esse exemplo abaixo.

Um ponto polêmico que acontece neste momento da história do componente, desde 2020, é o uso das placas de vídeo na mineração de criptomoedas como a Ethereum e o Bitcoin. A mineração é um processo que exige o máximo de poder computacional, o que também torna as placas de vídeo essenciais e visadas por esse mercado.

O uso das placas, normalmente voltadas para os jogos, para esse propósito, no entanto, elevou consideravelmente o custo dos componentes, o que é um dos fatores que aumentaram os preços das peças. Lembrando que elas já eram os componentes mais caros em relação ao restante das peças de um computador. Em nossa conversa com Richard Cameron, ele comentou sobre esse fenômeno.

"Nossa maior prioridade (da NVidia) são os jogadores. Por conta disso, a empresa está lançando no mercado linhas de placas de vídeo específicas para a mineração de criptomoedas, chamadas CMP" (Cryptocurrency Mining Processor). Apesar do mesmo poder de computação das placas para jogos, elas não contam com saída de vídeo."

Ou seja, você não pode ligar esse tipo de placa a um monitor gamer ou uma TV para jogos. Ainda não podemos dizer se a solução teve efeito, mas, como gamers, também queremos bastante que os preços das placas de vídeo diminuam!

O que esperar do computador do futuro?

Ao longo da história da informática, as tendências são bem claras: o computador foi ficando menor e mais potente. Prova disso são os smartphones e smartwatches, que também carregam processadores, telas e contam com um sistema operacional. Mas e se eu te dissesse que o futuro da informática pode ser de tamanho molecular?

Foi o que doutor Luciano Silva, coordenador do curso de Ciência da Computação na Universidade Presbiteriana Mackenzie, me contou. Com pesquisas na área de Astroinformática e Computação de Alto Desempenho, ele nos disse que já existem métodos de programar bactérias que são usadas para iluminar áreas dos oceanos contaminadas por petróleo, por exemplo.

Claro, vale mencionar que o provável é que essa tecnologia fique restrita ao campo acadêmico por um bom tempo. Só que esse não é o único caminho possível para o futuro da informática.

Na verdade, talvez já possamos chamar a computação quântica no presente, já que é possível acessar um ambiente de programação nessa modalidade de modo gratuito por meio da nuvem da Microsoft e da IBM. Em nossa conversa, o doutor Luciano mencionou que o que torna a computação quântica tão especial é que ela não utiliza o modelo binário criado por Alan Turing e que está presente nos computadores até hoje.

Ou seja, computadores quânticos não fazem cálculos com valores 0 ou 1, mas sim com os dois valores simultaneamente. Isso torna a execução de cálculos veloz de maneira inimaginável, uma ruptura de paradigma parecida com o que aconteceu lá na década de 1940 com o ENIAC.

Além da área acadêmica, perguntamos a alguns executivos da indústria o que pensam para o computador do futuro, mesmo que fosse um futuro próximo. Richard Cameron, o presidente da NVidia no Brasil que já citamos na matéria, nos contou que o que se sonha para o futuro em reprodução gráfica é o mesmo que já sonhávamos desde antes da virada do milênio: fidelidade gráfica tão precisa que se torna impossível distinguir o que é real do que é reproduzido por uma placa de vídeo.

Além disso, a NVIDIA também visiona um futuro da computação gráfica na nuvem. Parte disso é o serviço GeForce Now, que já está presente nos Estados Unidos e tem previsão de chegar aos gamers brasileiros entre agosto e setembro, como contamos primeiro aqui no Zoom.

Nesse serviço, você poderá acessar remotamente servidores da NVidia para aproveitar os jogos da sua biblioteca da Steam na maior qualidade possível, incluindo as versões recentes de tecnologias como o Ray Tracing e o DLSS 2.0.

Já Luciano Beraldo, gerente da área de notebooks da Samsung no Brasil, contou pra mim o que ele espera para o futuro dos computadores portáteis. Segundo ele, a "tendência de evolução dos notebooks é tornar-se um produto que pode ser colocado em uma bolsa ou mochila sem o usuário sequer perceber que o carrega, além de capacidade de adaptação a diversos ambientes sem nenhum prejuízo em seu desempenho."

Além disso, o executivo reforça bastante a capacidade de conectividade dos notebooks com outros dispositivos inteligentes.

"Os ambientes automatizados ganharão ainda mais força e as conexões que se aprimorarão ao longo dos próximos 10 anos, exigindo equipamentos eletrônicos integrados a um único sistema. A Samsung já trabalha com esse foco através da plataforma SmartThings, que integra o conceito de Internet das Coisas, garante conectividade e funciona como um controle remoto dos aparelhos inteligentes Samsung, via smartphone." Disse o executivo.

Por tudo o que pesquisamos e conversamos até aqui, duas tendências ficam bem claras: a conectividade entre aparelhos e a computação em nuvem chegaram para ficar, já se tornando agentes de mudança na nossa relação com os computadores. Aproveitar games de última geração em servidores remotos, utilizar computadores quânticos sem pagar nada por isso e com a capacidade de levar seu notebook a qualquer lugar já são realidade hoje e para o futuro próximo.

Em décadas de história, o computador evoluiu de uma simples calculadora superpoderosa para uma máquina multifunção. Agora, você pode acessar essas máquinas de qualquer lugar e quase por todos os dispositivos. Mais incrível ainda: bases que foram estabelecidas há quase um século estão começando a dar lugar a outras, mais arrojadas e fáceis de entender.

Ao que parece, o futuro será ainda mais conectado, acessível e com possibilidades quase infinitas de evolução na nossa capacidade de fazer grandes descobertas.

Fontes:

- https://www.britannica.com/biography/Charles-Babbage

- http://www.ime.unicamp.br/~apmat/ada-lovelace/

- https://www.newtoncbraga.com.br/index.php/curiosidades/4856-cur008

- https://www.livescience.com/20718-computer-history.html

- https://slate.com/culture/2014/12/the-imitation-game-fact-vs-fiction-how-true-the-new-movie-is-to-alan-turings-real-life-story.htmlhttps://www.britannica.com/biography/Alan-Turing

- https://time.com/3609585/the-true-story-of-the-imitation-game/

- https://www.historyofinformation.com/detail.php?id=623#:~:text=Stibitz's%20%22Model%20K%22%20(for,the%20Bell%20Labs%20Model%20I)

- https://history-computer.com/george-stibitz/

- https://en.wikipedia.org/wiki/George_Stibitz

- https://www.britannica.com/technology/ENIAC

- https://www.computerhistory.org/revolution/birth-of-the-computer/4/78#:~:text=In%201942%2C%20physicist%20John%20Mauchly,an%20all%2Delectronic%20calculating%20machine.&text=The%20result%20was%20ENIAC%20(Electronic,slowed%20by%20any%20mechanical%20parts

- https://www.computerhistory.org/timeline/1971/#169ebbe2ad45559efbc6eb35720a58a7

- https://www.ibm.com/ibm/history/exhibits/pc25/pc25_birth.html

- https://lowendmac.com/2006/origin-of-the-ibm-pc/

- https://apple2history.org/2010/10/25/the-competition-part-2/

- https://agenciabrasil.ebc.com.br/radioagencia-nacional/acervo/pesquisa-e-inovacao/audio/2018-07/historia-hoje-primeiro-computador-brasileiro-foi-criado-na-usp-ha/#:~:text=Em%2024%20de%20julho%20de,projetistas%20de%20o%20Patinho%20Feio.

- http://www.scielo.br/scielo.php?script=sci_arttext&pid=S0034-75901988000300012

- https://www.computerhope.com/history/laptop.htm#:~:text=Developed%20by%20Adam%20Osborne%20in,and%20had%20a%205%22%20display.&text=Epson%20released%20the%20Epson%20HX,with%20a%20built%2Din%20printer

- https://www.tecmundo.com.br/internet/2231-a-historia-dos-notebooks.htm

- https://www.thoughtco.com/history-of-laptop-computers-4066247

- https://plarium.com/en/blog/the-first-video-game/

- https://technical.city/pt/video/NV1